经过之前一系列的工作,进坑出坑的尝试,总算是把测试结果搞出来了,所以在此总结。并结合之前一些在google colab上的测试对比,将实际数据公布出来以供大家参考。

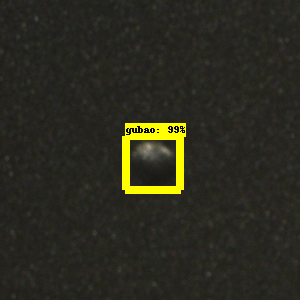

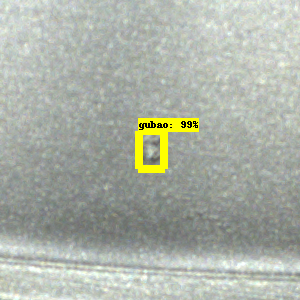

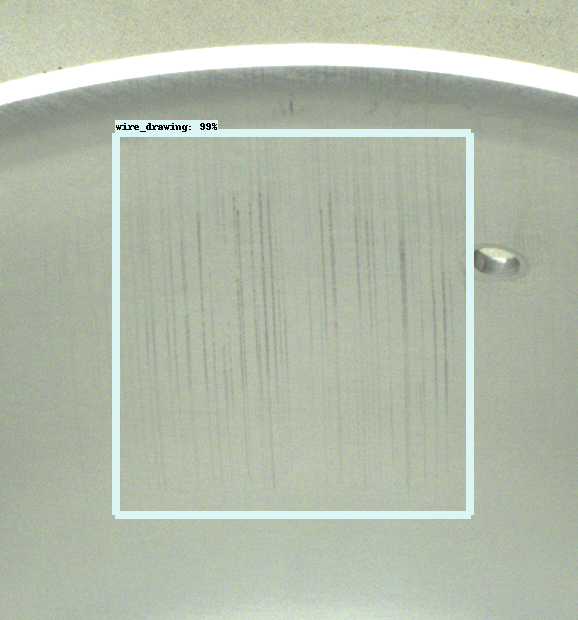

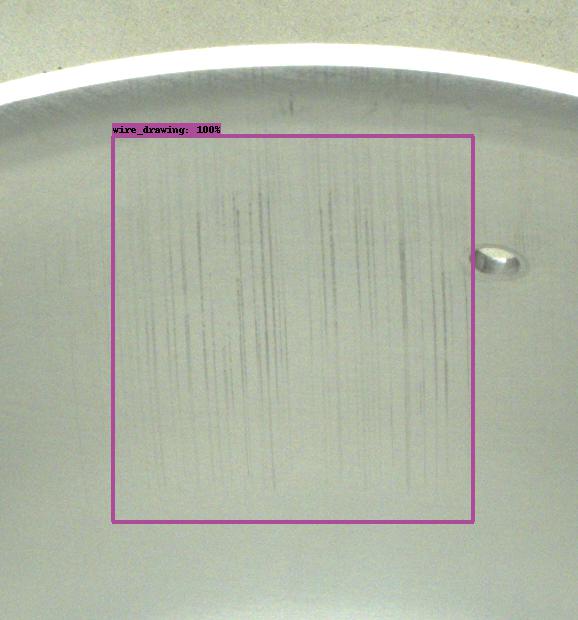

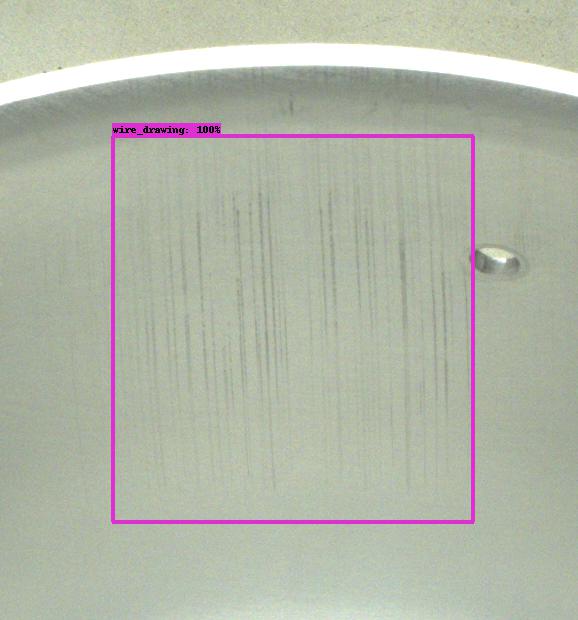

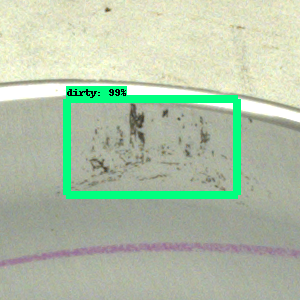

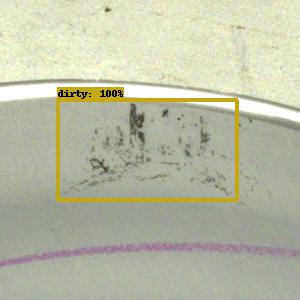

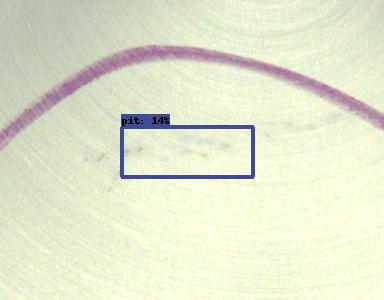

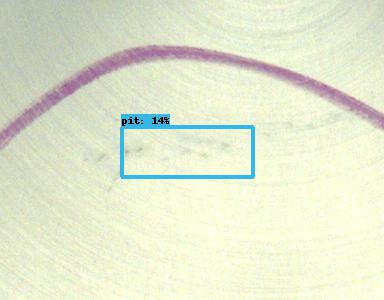

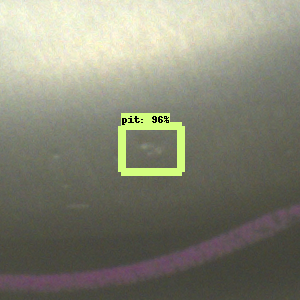

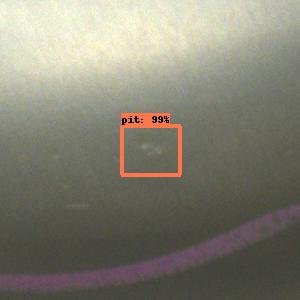

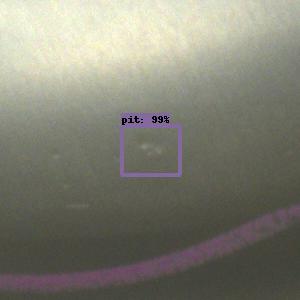

检测结果

|

21.9ms |  |

|

5ms | 5ms | ||||||

|

21.87ms |  |

|

7ms | 5ms | ||||||

|

21.75ms |  |

|

6ms | 5ms | ||||||

|

21.72ms |  |

|

5ms | 6ms | ||||||

|

21.86ms |  |

|

6ms | 5ms | ||||||

|

21.7ms |  |

|

5ms | 6ms | ||||||

|

21.48ms |  |

|

5ms | 5ms | ||||||

|

21.85ms |  |

|

5ms | 5ms | ||||||

| 结论:1. 无论从推测用时还是检测精度来看,tensorrt下选择精度为16或32的检测结果都基本无差;2. 用了tensorrt后的推理时长相比不用的时候能够提升4倍左右;3. 用了tensorrt后的预测精度相比不用的时候有所提升 | |||||||||||

| 结论: 1. 用了tensorrt后的推理时长相比不用的时候能够提升8-10倍左右;2. 一直到batch_size = 70GPU未饱和,并且最大利用率到70%左右,仍有剩余 | |||||||||||